Apache Hadoop是一个开源的大数据处理框架,主要用于存储和处理大规模数据集。它提供了分布式存储和计算能力,能够有效地处理海量数据。下面将介绍Hadoop的核心组件以及其在大数据处理中的应用。

核心组件

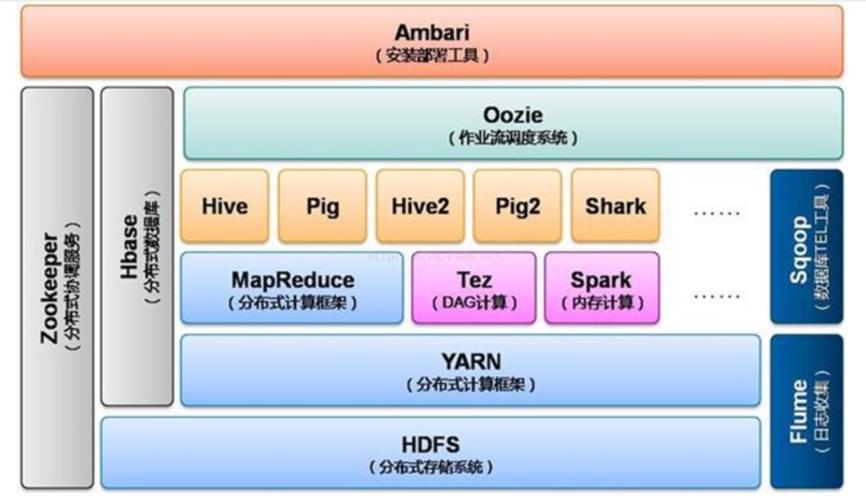

1. Hadoop Distributed File System (HDFS): HDFS是Hadoop的分布式文件系统,用于存储数据。它将数据分成多个块并存储在集群中的不同节点上,实现了高可靠性和高可扩展性。

2. MapReduce: MapReduce是Hadoop的计算框架,用于并行处理大规模数据集。它将任务分成Map和Reduce两个阶段,实现数据的分布式处理和计算。

3. YARN: YARN是Hadoop的资源管理器,负责集群资源的调度和管理。它可以同时运行多个应用程序,并动态分配资源以满足不同应用的需求。

应用场景

1. 大数据分析: Hadoop可以帮助企业处理海量数据,进行数据清洗、分析和挖掘,从而发现隐藏在数据中的有价值信息。例如,电商公司可以利用Hadoop分析用户行为数据,优化推荐系统和营销策略。

2. 日志处理: 许多互联网公司使用Hadoop来处理服务器日志和用户行为日志,以监控系统运行状况、分析用户行为和改进产品性能。

3. 图像识别: Hadoop可以与深度学习框架结合,用于处理大规模图像数据,实现图像识别、分类和检测。这在人脸识别、智能监控等领域有着广泛的应用。

指导建议

1. 熟悉Hadoop生态系统: 除了核心组件外,Hadoop还有许多相关工具和技术,如Hive、Spark、HBase等。建议深入了解Hadoop生态系统,选择适合自己需求的工具和技术。

2. 学习编程和数据处理技能: 使用Hadoop需要掌握编程语言(如Java、Python)、数据处理和分析技能。建议学习相关知识,提升数据处理能力。

3. 实践项目经验: 通过参与实际项目,积累Hadoop的实践经验。可以在开源社区、实习项目或个人项目中应用Hadoop,提升技能水平。

Hadoop作为大数据处理的重要工具,具有广泛的应用前景。掌握Hadoop技术,将有助于应对大数据处理的挑战,提升数据处理效率和质量。

标签: 大数据处理hadoop实训总结心得 hadoop大数据处理实战 hadoop大数据处理毕业设计

还木有评论哦,快来抢沙发吧~