大数据是指传统数据管理工具不足以处理的海量、高增长率和多样化的信息资产。大数据处理通常涉及数据采集、存储、处理、分析和可视化,以发现隐藏在数据背后的模式、趋势和见解。

在进行大数据实验时,通常会涉及以下基本概念:

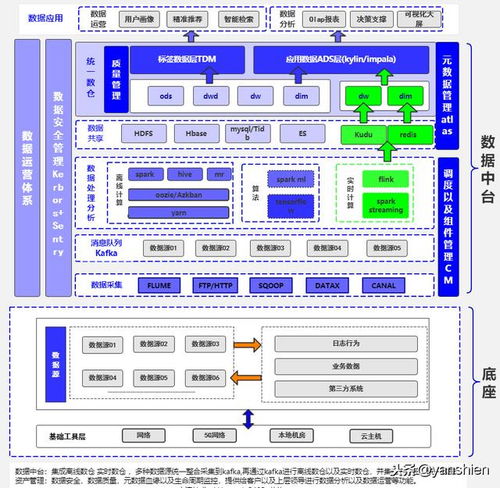

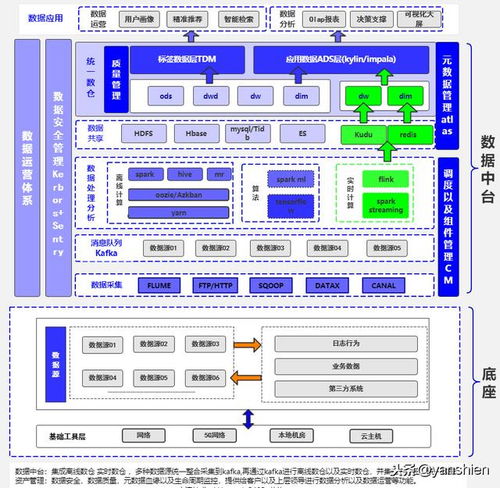

数据采集: 这是指从各种来源收集数据的过程,包括传感器、社交媒体、日志文件、数据库等。在实验中,你可以尝试使用开源工具如Apache Flume或Apache NiFi来收集数据。

数据存储: 一旦数据被采集,它需要被存储起来以备后续处理和分析。Hadoop分布式文件系统(HDFS)是一个常用的选择,也可以考虑使用NoSQL数据库,比如MongoDB或Cassandra。在实验中,你可以尝试搭建一个简单的Hadoop集群,并将数据存储在HDFS中。

数据处理: 大数据处理通常涉及到分布式计算,其中MapReduce是一个常用的范式。你可以利用Apache Spark或Apache Flink进行数据处理实验,比如对大规模数据进行排序或聚合操作。

数据分析: 数据分析是大数据的关键部分,它可以帮助你发现数据中的模式、趋势和见解。你可以尝试使用数据挖掘算法、机器学习模型或实时数据处理技术来分析你的数据。

可视化: 通过数据可视化,你可以把复杂的数据转化为易于理解的图表、图形或地图。在实验中,你可以使用工具如Tableau、D3.js或Matplotlib来为你的数据生成可视化报告。在实验过程中,你可能会遇到各种挑战,比如数据安全性、性能优化、实时处理等问题。因此,在做大数据实验时,务必不断学习、尝试新技术,并思考如何将其应用到实际场景中。

大数据实验是一个学习和探索的过程,希望你在实验中能够不断积累经验,提升自己的技能。

标签: 大数据基础实验结果与分析

大数据基本概念实验总结怎么写

大数据概论实验报告

大数据实验原理

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

还木有评论哦,快来抢沙发吧~