了解大数据中的HDFS功能

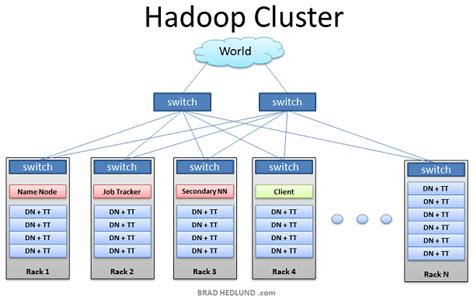

在大数据领域,HDFS(Hadoop分布式文件系统)是一个核心组件,它被设计用来存储和处理大规模数据集。HDFS的功能涵盖了数据存储、数据备份、数据冗余、数据可靠性和数据处理等方面。以下是关于HDFS功能的详细解释:

HDFS通过将大数据集分成小数据块并存储在集群中的多台服务器上,实现了高效的数据存储。默认情况下,数据块的大小为128MB或256MB,这有助于提高数据的读取和写入性能。

HDFS通过在集群中多个节点上存储数据的多个副本来实现数据备份和冗余。通常情况下,每个数据块都会有3个副本存储在不同的节点上,这样即使某个节点发生故障,数据仍然可以从其他节点获取,保证了数据的可靠性和容错性。

由于HDFS存储数据的冗余性,即使在节点发生故障或数据损坏的情况下,数据仍然是可靠和完整的。HDFS会自动检测到数据损坏,并从副本中选择一个可用的副本进行数据恢复,以确保数据的可靠性。

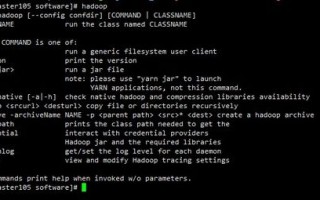

除了作为数据存储系统之外,HDFS还提供了数据处理功能。Hadoop生态系统中的其他组件,如MapReduce、Apache Spark等,可以直接从HDFS中读取数据,并在集群上进行分布式数据处理,从而实现大规模数据分析和计算。

对于使用HDFS的企业或组织,以下是一些指导建议:

HDFS在大数据领域扮演着重要的角色,它不仅提供了高效可靠的数据存储功能,还为数据处理和分析提供了强大的支持。通过合理规划和管理,企业可以充分利用HDFS的功能,实现数据的存储、备份和处理,从而推动业务的发展和创新。

标签: 大数据hdfs创建文件的方法有哪些 大数据hdfs是指 大数据分布式文件系统hdfs 大数据存储方法hdfs 大数据基本概念hdfs

评论列表

大数据HDFS创建文件方法多样,便捷高效