大数据统计建模报告

大数据统计建模报告是基于大数据分析的结果,通过统计建模的方法对数据进行深入挖掘和分析,并形成相应的报告。这样的报告可以为企业决策提供重要的参考依据,帮助企业更好地了解市场、客户和产品等方面的情况,从而制定更有效的战略。

在进行大数据统计建模之前,首先需要收集相关的数据。这些数据可以来自于企业内部的数据库,也可以来自外部的数据源,比如互联网、传感器等。收集到的数据可能会存在各种各样的问题,比如缺失值、异常值、重复值等,因此在进行建模之前需要对数据进行预处理,以确保数据的质量。

预处理的过程包括数据清洗、数据转换、数据集成和数据规约等步骤。数据清洗主要是处理缺失值、异常值和重复值,数据转换可以将数据进行标准化或归一化,数据集成则是将多个数据源的数据进行整合,数据规约则是对数据进行降维处理,以减少数据的复杂度。

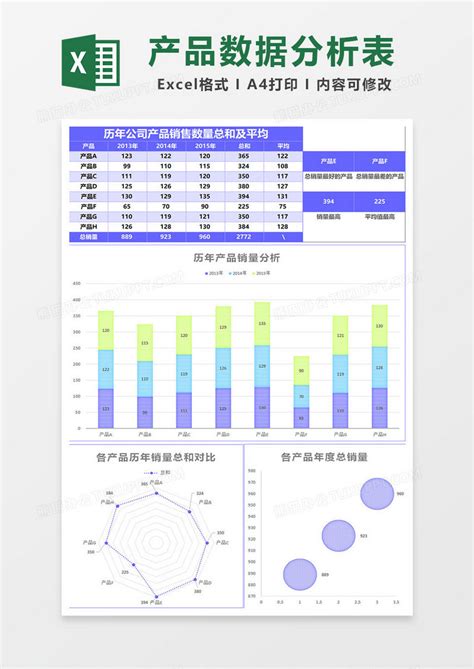

在数据预处理之后,接下来是数据探索与分析的阶段。这个阶段的主要目的是通过可视化和统计方法对数据进行探索,了解数据的特征和规律,发现数据之间的关联性,为后续的建模工作做准备。

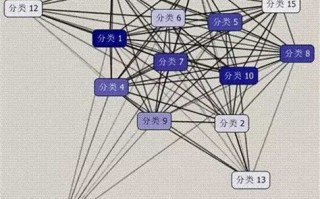

数据探索与分析的方法包括描述性统计分析、相关性分析、聚类分析、主成分分析等。通过这些方法,可以对数据的分布、趋势、异常情况等进行全面的分析,从而更好地理解数据。

在数据探索与分析的基础上,可以开始建立统计模型进行预测或分类。常用的统计建模方法包括线性回归、逻辑回归、决策树、随机森林、支持向量机等。

建立模型之后,需要对模型进行评估,以确保模型的准确性和稳定性。常用的模型评估指标包括准确率、精确率、召回率、F1值等。通过这些指标,可以评估模型的预测能力和泛化能力,从而确定是否需要对模型进行调整或优化。

需要将模型的结果进行解释,并形成相应的报告。报告应该清晰地呈现模型的预测结果、关键特征、影响因素等信息,同时也需要对模型的局限性和不确定性进行说明。

报告的内容应该针对不同的受众进行调整,比如对于高层管理者,可以重点介绍模型对业务决策的影响;对于技术人员,可以详细介绍模型的建立过程和技术细节。

建立好统计模型之后,并不意味着工作的结束,相反,持续优化与更新是非常重要的。随着时间的推移,数据和业务环境可能会发生变化,因此需要不断地监控模型的表现,并根据需要进行调整和更新。

持续优化与更新可以通过引入新的数据、调整模型参数、采用新的算法等方式来实现。这样可以保持模型的准确性和有效性,确保模型始终能够为企业决策提供有力的支持。

大数据统计建模报告是对大数据分析结果的总结和归纳,是企业决策的重要参考依据。通过数据收集与预处理、数据探索与分析、模型建立与评估、结果解释与报告以及持续优化与更新等步骤,可以建立起有效的统计模型,并将模型的结果转化为实际的业务价值。

标签: 大数据建模论文 大数据模型建模 大数据分析数据建模 大数据建模思路

还木有评论哦,快来抢沙发吧~