大数据处理是指对体量巨大、类型繁多的数据进行分析、处理和应用的过程。Hadoop是一种开源的分布式存储和处理大数据的框架,它能够处理包括结构化数据、半结构化数据和非结构化数据在内的大数据。

1. Hadoop的核心组件

Hadoop的核心组件包括:

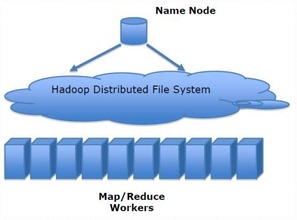

- HDFS(Hadoop分布式文件系统): 用于存储大数据的分布式文件系统。

- MapReduce: 用于分布式计算的编程模型和处理引擎。

- YARN(资源调度与管理): 用于集群资源的管理和调度。

2. Hadoop大数据处理的流程

基于Hadoop的大数据处理通常分为以下几个步骤:

3. Hadoop生态系统工具

Hadoop生态系统提供了丰富的工具和框架,包括:

- Hive: 类似于SQL的数据仓库工具,用于数据汇总、查询和分析。

- Pig: 用于进行复杂数据流的分析。

- HBase: 面向列的分布式数据库。

- Spark: 快速通用的集群计算系统,支持内存计算。

- Flink: 高性能的流处理引擎。

4. Hadoop大数据处理的最佳实践

在进行Hadoop大数据处理时,有一些最佳实践值得注意:

总结

Hadoop作为目前流行的大数据处理框���,为处理海量数据提供了有效的解决方案。通过合理利用Hadoop生态系统中的工具和技术,可以实现对大数据的高效处理、存储和分析,为企业决策和业务创新提供支持。

标签: hadoop大数据处理代码 hadoop大数据处理技术 hadoop大数据处理技术考试 hadoop大数据处理李歆

版权声明:除非特别标注,否则均为本站原创文章,转载时请以链接形式注明文章出处。

还木有评论哦,快来抢沙发吧~