ETL是指数据抽取(Extraction)、转换(Transformation)、加载(Loading)的过程,是大数据处理中非常重要的一环。对于大数据ETL加工处理,以下是一些关键要点:

1. 数据抽取(Extraction)

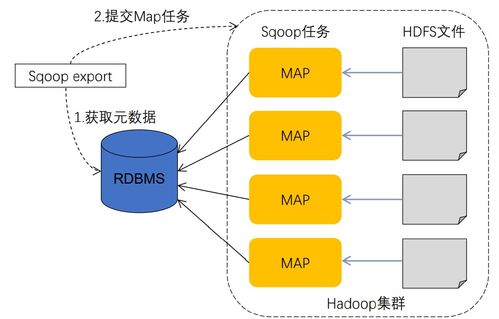

在数据抽取阶段,从不同数据源(如关系型数据库、日志文件、API接口等)中提取数据。在大数据环境下,通常会采用分布式抽取工具,如Sqoop、Flume等。抽取的数据需要考虑数据量、抽取频率、抽取方式等因素。

2. 数据转换(Transformation)

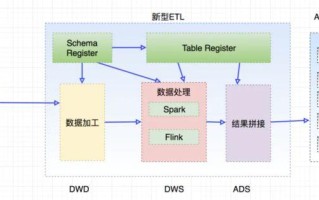

数据转换是ETL过程中最重要的环节之一,通过清洗、清理、归并、聚合等操作,将抽取的数据转换为目标数据模型需要的格式和结构。在大数据环境中,通常会使用MapReduce、Spark等技术进行数据转换。数据转换还包括处理脏数据、重复数据、缺失数据等问题。

3. 数据加载(Loading)

数据加载是将经过转换的数据加载到目标数据存储中,如HDFS、Hive、HBase等。在数据加载阶段,还需要考虑数据格式、数据分区、数据压缩等问题,以提高数据的加载效率和查询性能。

4. 数据质量监控

在ETL过程中,数据质量监控至关重要。建议引入数据质量管理工具,监测数据抽取、转换、加载过程中数据的完整性、一致性、准确性等指标,并及时处理数据质量异常。

5. 性能优化

为提高ETL处理效率,可以采取一些性能优化策略,如增量抽取、并行处理、数据分片、缓存优化等。定期检查ETL任务的性能指标,及时调整参数和优化ETL流程。

6. 容错与重试机制

考虑到大数据处理过程中可能出现的网络故障、数据错误等情况,建议设置容错机制和重试策略,确保ETL任务的稳定性和可靠性。可以结合监控系统,实现实时告警和异常处理。

大数据ETL加工处理是复杂而关键的工作,需要综合考虑数据规模、数据质量、性能等多个方面因素。通过合理的规划、技术选型和流程优化,可以提高数据处理效率、降低运维成本,为业务决策提供可靠的数据支持。

标签: 大数据etl技术 大数据etl是啥 大数据etl工具 大数据etl开发公司 大数据etl开发

还木有评论哦,快来抢沙发吧~