ETL(Extract, Transform, and Load)是一种用于将数据从源系统提取、转换和加载到目标系统的过程。大数据分析系统则是利用大数据技术进行数据分析和挖掘的系统。本文将介绍ETL大数据分析系统的基本原理、关键组成部分以及指导建议。

一、ETL大数据分析系统的基本原理

ETL大数据分析系统的基本原理如下:

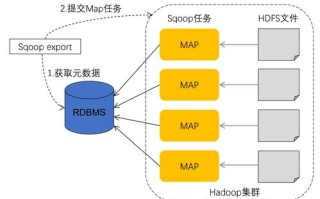

1. 提取(Extract):从各种数据源(如关系型数据库、非关系型数据库、文件等)中提取数据。这些数据源可以是结构化数据(如表格形式)或非结构化数据(如日志文件、社交媒体数据等)。数据提取通常涉及数据的抽取、过滤和清洗等操作。

2. 转换(Transform):对提取的数据进行转换和加工,以满足分析需求。转换操作可以包括数据清洗、数据集成、数据转换和数据规范化等。转换的目标是将源数据转化为符合分析要求的数据格式和结构。

3. 加载(Load):将转换后的数据加载到目标系统(如数据仓库、数据湖等)中,供分析师和决策者使用。数据加载涉及数据的存储和索引,以支持快速查询和分析。

二、ETL大数据分析系统的关键组成部分

ETL大数据分析系统由以下关键组成部分构成:

1. 数据源:数据源可以包括各种传统的数据存储系统(如关系型数据库、文件系统)以及现代的大数据存储系统(如Hadoop、NoSQL数据库等)。数据源的选择应根据数据的类型、规模和分析要求来确定。

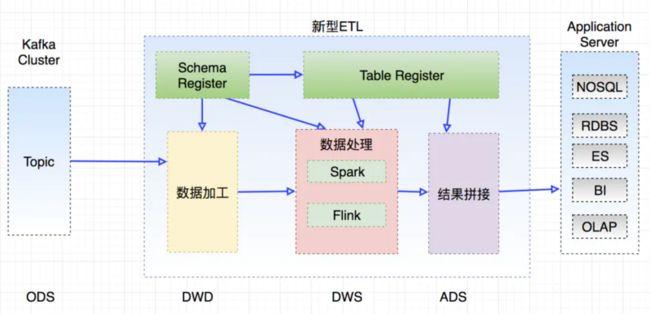

2. ETL工具:ETL工具是实现ETL过程的关键组件。常见的ETL工具包括Informatica、Talend、Pentaho和Apache NiFi等。这些工具提供了强大的数据集成、转换和加载功能,并支持任务调度、监控和错误处理等。

3. 数据仓库/数据湖:数据仓库和数据湖是用于存储和管理分析数据的中心化存储系统。数据仓库通常采用星型或雪花型的数据模型,并支持多维分析。数据湖则是将数据以原始格式存储在分布式文件系统中,以支持灵活的数据查询和分析。

4. 数据质量管理:由于数据源的复杂性和多样性,数据质量管理成为ETL大数据分析系统中的重要环节。数据质量管理涉及数据清洗、去重、校验和补全等操作,以确保分析结果的准确性和一致性。

5. 分析工具:ETL大数据分析系统的最终目标是为分析师和决策者提供可靠、准确的数据分析结果。分析工具可以包括BI工具(如Tableau、Power BI)、数据挖掘工具(如R、Python)和机器学习工具(如Spark MLlib、TensorFlow)等。

三、指导建议

搭建和优化ETL大数据分析系统需要考虑以下几点:

1. 数据需求分析:在搭建ETL大数据分析系统之前,首先要明确分析需求和目标。根据分析需求确定所需的数据源、ETL工具和分析工具,并进行合理的系统架构设计。

2. 数据质量管理:数据质量是影响分析结果准确性的关键因素,因此需要在ETL过程中加入数据质量管理环节。开发数据质量规则和检验机制,及时发现并修复数据质量问题。

3. 并行处理和性能优化:由于大数据分析系统涉及大量数据的处理和计算,需要采用并行处理技术(如MapReduce、Spark)来提高系统的处理效率。还可以通过调整ETL任务的并发度、优化SQL查询和索引设计等措施来提升系统性能。

4. 监控和调优:建立完善的监控和调优机制,及时检测系统中的潜在问题(如数据延迟、任务失败等)并进行优化。监控指标可以包括数据提取速度、转换质量、加载效率等。

ETL大数据分析系统可以帮助企业从多个数据源中提取、转换和加载数据,为分析师和决策者提供准确、及时的数据分析结果。在搭建和优化ETL大数据分析系统时,需要考虑数据需求分析、数据质量管理、并行处理和性能优化以及系统的监控和调优等方面。

标签: 传统etl和大数据etl的发展 etl数据分析工具 大数据etl开发 大数据常用的etl工具

还木有评论哦,快来抢沙发吧~