大数据爬虫技术:从数据采集到分析的关键方法和技巧

简介:

大数据爬虫技术是指通过网络爬虫程序自动获取互联网上的数据,并进行处理和分析。在大数据时代,大量的数据来源于互联网,爬虫技术成为获取和处理这些数据的重要工具。本文将介绍大数据爬虫技术的基本原理,并详细介绍一些常用的大数据爬虫技术和相关的注意事项。

一、基本原理

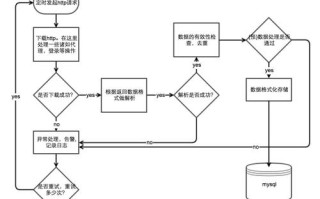

大数据爬虫的基本原理是模拟浏览器的行为,通过网络请求获取目标网站上的数据,并将数据保存到本地或发送到数据处理服务器中。以下是大数据爬虫的基本流程:

1.分析目标:确定需要采集的目标网站和数据类型。

2.制定策略:确定数据采集的规则和策略,如数据的起始页、分页方式等。

3.编写爬虫程序:使用编程语言(如Python、Java等)编写爬虫程序,通过网络请求获取目标网站上的数据。

4.数据处理和存储:对获取到的数据进行清洗、整理和存储,以备后续的数据分析使用。

二、常用的大数据爬虫技术和相关注意事项

1.基于网页的爬虫技术:

使用HTTP请求库:通过发送HTTP请求,获取网页的HTML源码,并利用正则表达式或HTML解析库提取所需数据。

使用自动化测试工具:使用工具如Selenium或Puppeteer来模拟浏览器的行为,获取加载后的页面内容。

使用Web API:一些网站提供API接口让开发者获取数据,可以直接调用API接口获取数据。

注意事项:

需要了解目标网站的访问限制,避免触发网站的反爬机制。

需要设置合理的爬取频率,避免给目标网站带来过大的请求负担。

需要处理网页异步加载的情况,确保获取到完整的数据。

2.基于API的爬虫技术:

使用公开的API数据:一些网站提供公开的API接口,可以直接调用获取数据。

使用反向工程获取API数据:通过分析网页请求,获取API接口的URL和参数,进行调用和数据的获取。

注意事项:

需要检查目标网站的API使用规则和限制,确保合法的访问和使用。

需要对API数据进行解析和处理,提取所需的信息。

3.分布式爬虫技术:

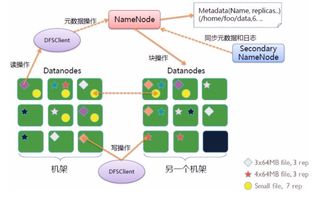

使用分布式爬虫框架:如Scrapy、Apache Nutch等,通过多个节点同时进行数据的采集和处理,加快爬取速度。

使用分布式存储和计算框架:如Hadoop、Spark等,进行数据的存储和分析。

注意事项:

需要合理规划和配置分布式爬虫系统的节点数量和任务分配,以充分利用资源并避免冲突和重复爬取。

需要进行错误处理和容错机制的设计,确保系统的稳定性和可靠性。

大数据爬虫技术是获取和处理互联网上大量数据的关键技术之一。通过合理选择爬虫技术和注意事项的遵守,可以高效地获取所需的数据,并为后续的数据分

标签: 大数据爬虫能爬到用户数据吗 大数据 爬虫 大数据爬虫技术有哪些 大数据爬虫技术是什么 大数据爬虫技术有哪些类型

还木有评论哦,快来抢沙发吧~